Emotional Reaction Intensity Estimation Based on Multimodal Data

文章比较简短,因为是一场竞赛中所用到的方法撰写的,是CVPR 2023:第五届野外情感行为分析(ABAW)研讨会和比赛中对情绪反应强度(ERI)估计挑战的方法。

论文题目(Title):Emotional Reaction Intensity Estimation Based on Multimodal Data

基于多模态数据的情绪反应的强度计算

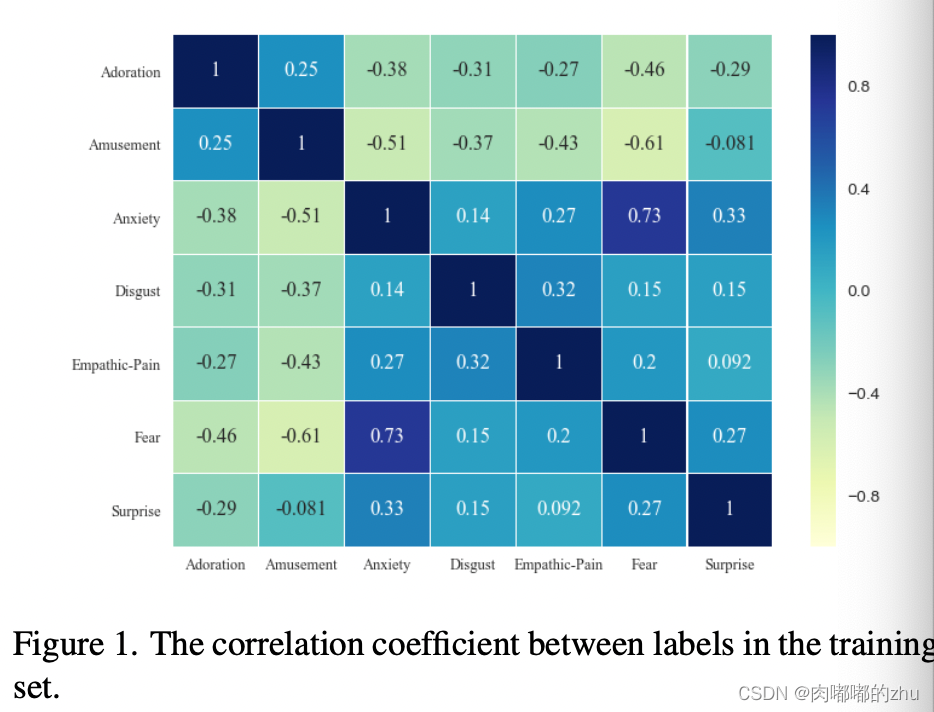

研究问题(Question):Emotional Reaction Intensity (ERI) 情绪反应强度评估挑战,旨在预测观众七种不同情绪的强度。

研究动机(Motivation):情绪反应包括面部表情、言语、手势。这些多模态数据通常受到环境的干扰,如光线、噪音、相机的质量等。即使是数据的不同部分也会相互影响,从而使估计更加困难。ERI估计需要仔细利用和分析这些多模态数据来创建一个模型,该模型通过分析语音信息、视觉信息和手势信息,能够较好地识别人的情绪状态。

主要贡献(Contribution):

1. 使用一些预训练模型提取音频视频特征;

2. 提高了皮尔逊系数(两个变量之间的相关性);

3. 微调数据,提高模型性能。

研究思路(Idea):首先,以0.2秒的间隔从视频中获取视频帧。获取视频帧后,使用DeepFace按时间顺序获取视频帧中的人脸,保存224x224张人脸图像。利用FAB- Net、DAN、EfficientNet

获取面部信息编码。利用Wav2Vec2、VGGish获取音频特征编码。

研究方法(Method):方法主要基于一个CNN和一个变压器-编码器。首先,将之前提取的特征作为一维时间卷积网络的输入,提取局部时间信息。然后,将一维CNN的输出输入transformer编码器实现与动态注意力权重的长期依赖。最后,利用全连通层对情绪反应强度进行推理。

研究过程(Process):主要是将面部信息、音频信息进行拼接。

1.数据集(Dataset)

比赛提供的数据集

2.评估指标(Evaluation)

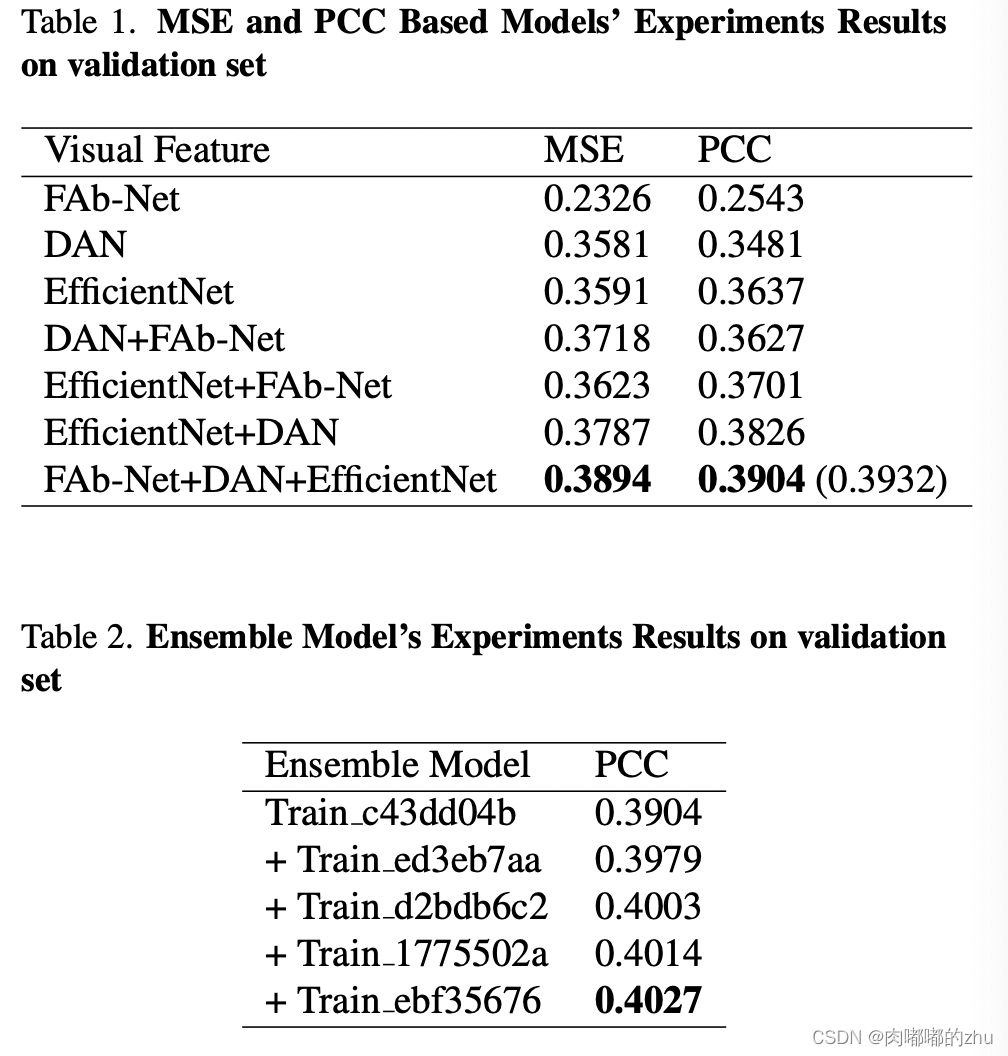

MSE损失和PCC损失,平均损失函数越小越好;PCC度量两个变量之间的关系,越大越好。

3.实验结果(Result)

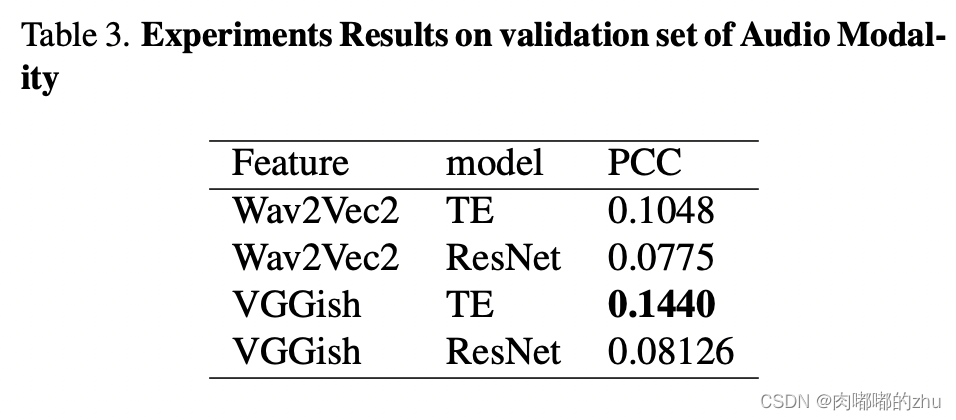

总结(Conclusion):利用TE网络和VGGish提取的特征,在验证集上得到了平均Pearson相关系数为0.1440。

上一篇:【游戏逆向】《天堂2》背包分析

下一篇:Java的运行机制详解