突然宣布!暂停DeepSeek API服务

【导读】DeepSeek一天能赚多少钱?官方突然揭秘!潞晨科技暂停DeepSeek API服务

中国基金报记者 泰勒

大家好,一起关注一下关于DeepSeek的最新消息!

DeepSeek首次披露:理论成本利润率545%

当市场以为DeepSeek的开源周内容发布完毕之后,3月1日,DeepSeek宣布了“One More Thing”,突然揭秘V3/R1推理系統,公开了大规模部署成本和收益。

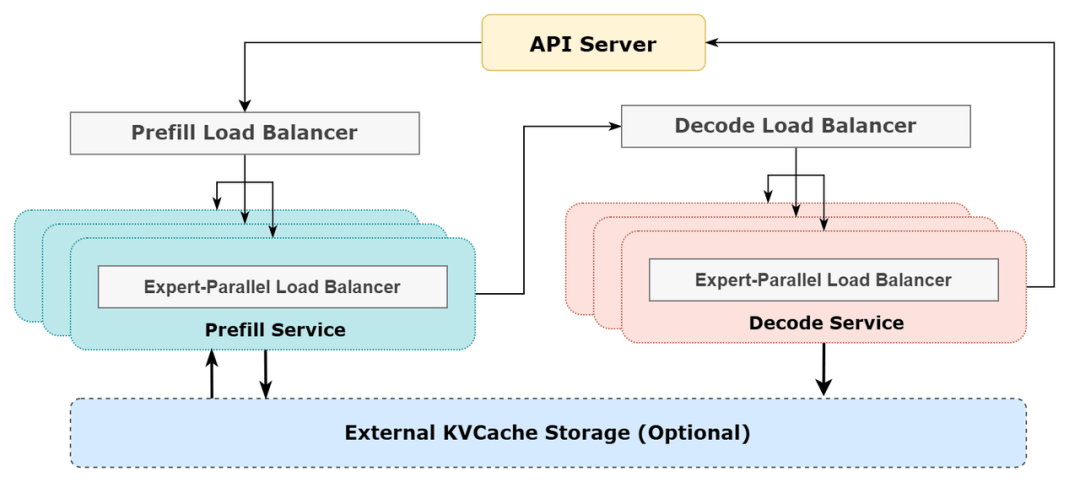

据官方披露, DeepSeek-V3/R1推理系统的优化目标是:更大的吞吐,更低的延迟。

为了实现这两个目标,DeepSeek使用大规模跨节点专家并行(Expert Parallelism / EP)。首先EP使得batch size大大增加,从而提高GPU矩阵乘法的效率,提高吞吐。其次EP使得专家分散在不同的GPU上,每个 GPU 只需要计算很少的专家(因此更少的访存需求),从而降低延迟。

但EP同时也增加了系统的复杂性。复杂性主要体现在两个方面:

EP引入跨节点的传输。为了优化吞吐,需要设计合适的计算流程使得传输和计算可以同步进行。

EP涉及多个节点,因此天然需要Data Parallelism(DP),不同的DP之间需要进行负载均衡。

因此,DeepSeek介绍了如何使用EP增大batch size,如何隐藏传输的耗时,如何进行负载均衡。

大规模跨节点专家并行(Expert Parallelism / EP)

由于DeepSeek-V3/R1的专家数量众多,并且每层256个专家中仅激活其中8个。模型的高度稀疏性决定了必须采用很大的overall batch size,才能给每个专家提供足够的expert batch size,从而实现更大的吞吐、更低的延时。需要大规模跨节点专家并行(Expert Parallelism / EP)。

采用多机多卡间的专家并行策略来达到以下目的:

Prefill:路由专家EP32、MLA和共享专家DP32,一个部署单元是4节点,32个冗余路由专家,每张卡9个路由专家和1个共享专家。

Decode:路由专家EP144、MLA和共享专家DP144,一个部署单元是18 节点,32个冗余路由专家,每张卡2个路由专家和1个共享专家。

计算通信重叠

多机多卡的专家并行会引入比较大的通信开销,所以使用了双batch重叠来掩盖通信开销,提高整体吞吐。

对于prefill阶段,两个batch的计算和通信交错进行,一个batch在进行计算的时候可以去掩盖另一个batch的通信开销;

对于decode阶段,不同阶段的执行时间有所差别,所以把attention部分拆成了两个stage,共计5个stage的流水线来实现计算和通信的重叠。

尽可能地负载均衡

由于采用了很大规模的并行(包括数据并行和专家并行),如果某个GPU的计算或通信负载过重,将成为性能瓶颈,拖慢整个系统;同时其他GPU因为等待而空转,造成整体利用率下降。因此需要尽可能地为每个GPU分配均衡的计算负载、通信负载。

PrefillLoadBalancer

核心问题:不同数据并行(DP)实例上的请求个数、长度不同,导致core-attention计算量、dispatch发送量也不同。

优化目标:各GPU的计算量尽量相同(core-attention计算负载均衡)、输入的token数量也尽量相同(dispatch发送量负载均衡),避免部分GPU处理时间过长。

DecodeLoadBalancer

核心问题:不同数据并行(DP)实例上的请求数量、长度不同,导致core-attention计算量(与KVCache占用量相关)、dispatch发送量不同。

优化目标:各GPU的KVCache占用量尽量相同(core-attention计算负载均衡)、请求数量尽量相同(dispatch发送量负载均衡)。

Expert-ParallelLoadBalancer

核心问题:对于给定MoE模型,存在一些天然的高负载专家(expert),导致不同GPU的专家计算负载不均衡。

优化目标:每个GPU上的专家计算量均衡(即最小化所有GPU的dispatch接收量的最大值)。

线上系统的实际统计数据

DeepSeekV3和R1的所有服务均使用H800GPU,使用和训练一致的精度,即矩阵计算和dispatch传输采用和训练一致的FP8格式,core-attention计算和combine传输采用和训练一致的BF16,最大程度保证了服务效果。

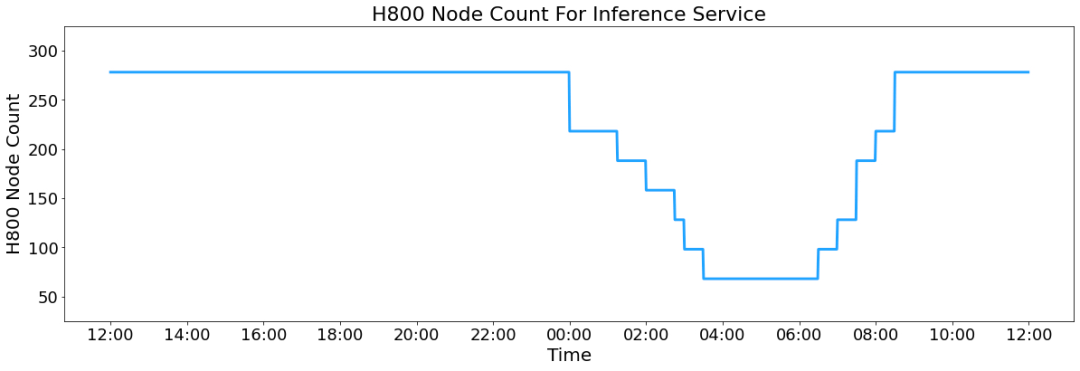

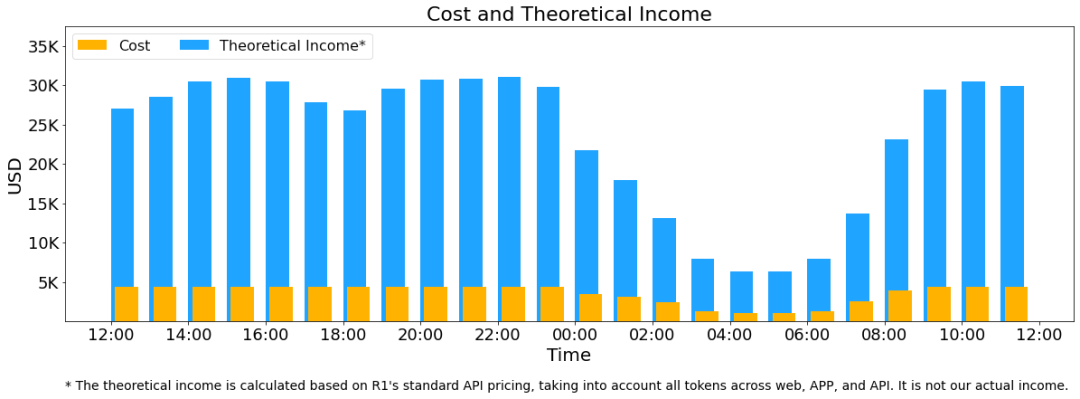

另外,由于白天的服务负荷高,晚上的服务负荷低,因此实现了一套机制,在白天负荷高的时候,用所有节点部署推理服务。晚上负荷低的时候,减少推理节点,以用来做研究和训练。在最近的24小时里(北京时间2025/02/27 12:00至2025/02/28 12:00),DeepSeek -V3和R1推理服务占用节点总和,峰值占用为278个节点,平均占用226.75个节点(每个节点为8个H800GPU) 。 假定GPU租赁成本为2美金/小时,总成本为87072美元/天。

在24小时统计时段内,DeepSeek-V3和R1:

输入token总数为608B,其中342Btokens(56.3%)命中KVCache硬盘缓存。

输出token总数为168B。平均输出速率为20~22tps,平均每输出一个token的KVCache长度是4989。

平均每台H800的吞吐量为:对于prefill任务,输入吞吐约73.7ktokens/s(含缓存命中);对于decode任务,输出吞吐约14.8ktokens/s。

有网友将DeepSeek与OpenAI进行对比,表示:“‘成本利润率545%’,等一下,所以你是说我被OpenAI抢劫了?”

潞晨科技暂停DeepSeek API服务

就在DeepSeek披露大规模部署成本和收益之后,潞晨科技突然宣布:“尊敬的用户,潞晨云将在一周后停止提供DeepSeek API服务,请尽快用完您的余额。如果没用完,我们全额退款。 ”

此前2月4日晚间,华为计算微信公众号发文表示,DeepSeek-R1系列模型的开源,因其出色的性能和低廉的开发成本,已引发全球的热切讨论和关注。潞晨科技携手昇腾,联合发布基于昇腾算力的DeepSeek-R1系列推理API,及云镜像服务。

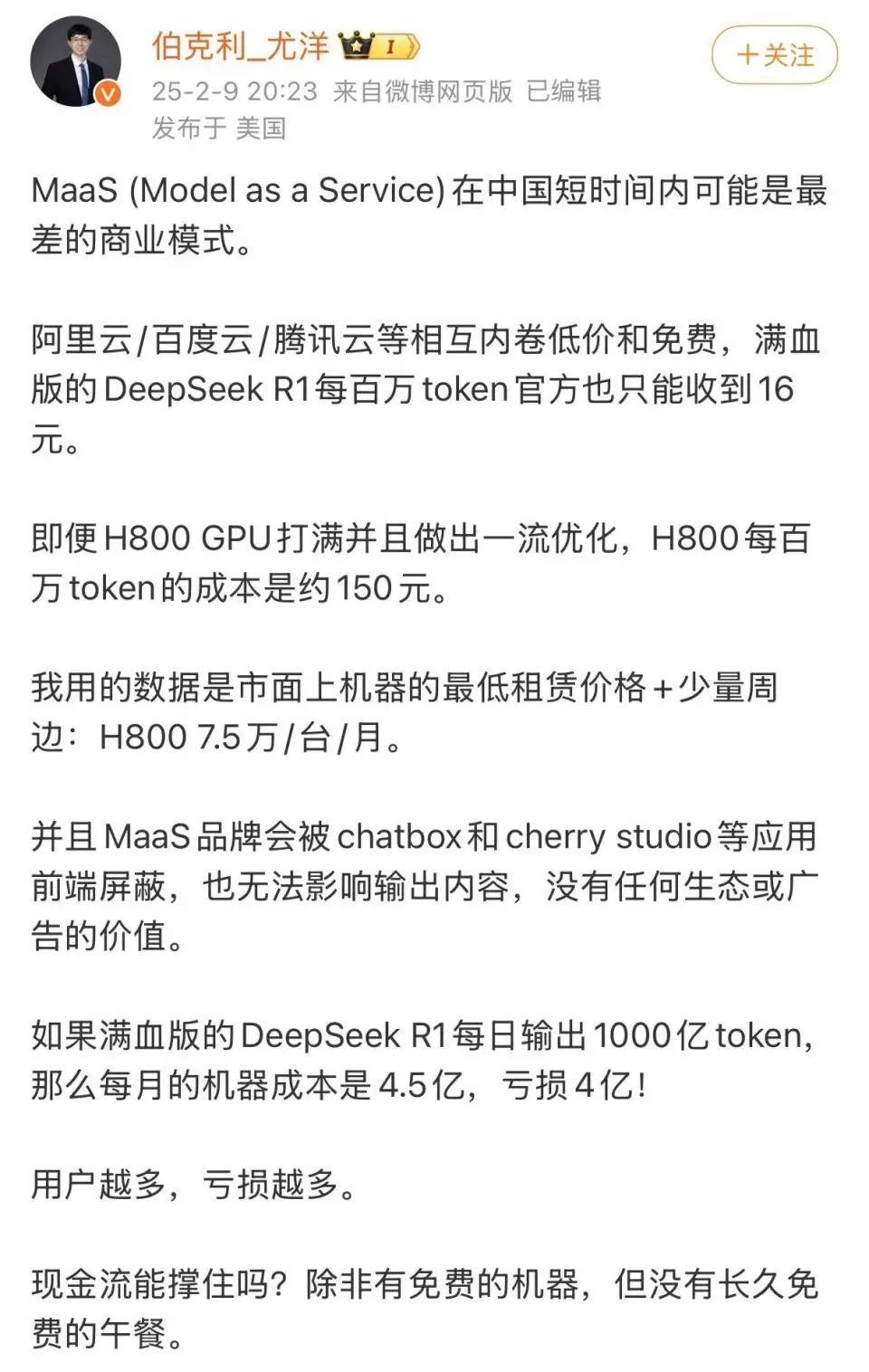

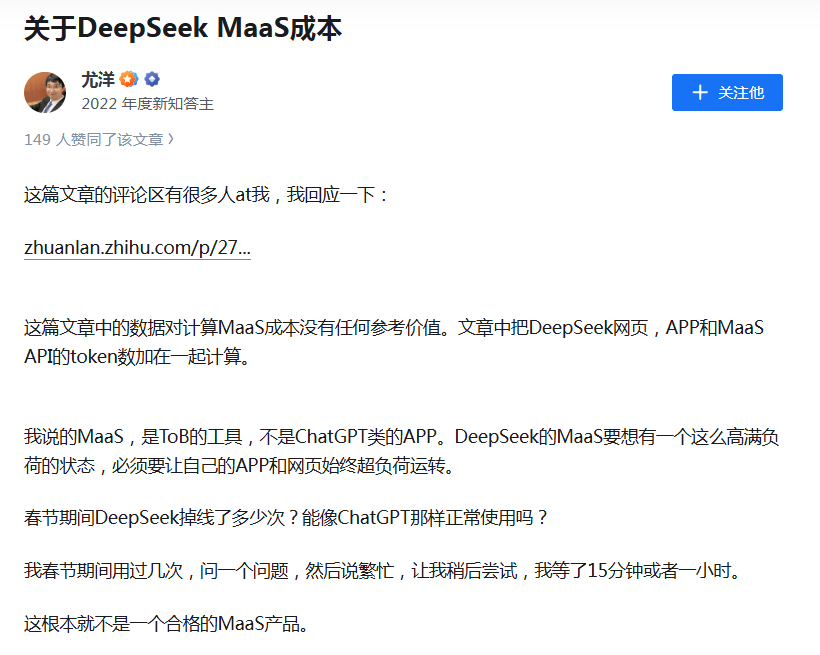

但近期潞晨科技CEO尤洋指出,满血版DeepSeek-R1每百万token(输出)定价16元,如果每日输出1000亿token,一个月算下来接入方企业可获得4800万元收入。据他测算,完成1000亿token的输出,需要约4000台搭载H800的机器,以目前H800的市价或者折旧来计算,每月仅机器成本就达4.5亿元,因此企业方可能面临每月4亿元的亏损,“用户越多,服务成本越高,亏损越多”。

3月1日下午4点, 潞晨科技CEO尤洋发文回应 DeepSeek公布的理论成本利润率。

公开资料显示,潞晨科技是一家致力于“解放AI生产力”的全球性企业,团队核心成员来自美国加州大学伯克利分校,斯坦福大学,清华大学,北京大学等国内外知名高校。主营业务包括分布式软件系统,大规模人工智能平台,以及企业级云计算解决方案。公司旨在打造一个开源低成本AI大模型开发系统Colossal-AI,作为深度学习框架的内核,帮助企业最大化人工智能训练效率的同时最小化人工智能的训练成本。

校对:纪元

编辑:嘉颖

审核:许闻